Prüfungen und KI: Die Illusion der Kontrolle (Teil 1/4)

Artikelserie: Prüfungen und KI

Dies ist Teil 1 von 4 einer Artikelserie basierend auf meiner Keynote beim Tag der digitalen Lehre am 25.09.2025 in Regensburg.

In dieser Serie:

- Die Illusion der Kontrolle – Symptombekämpfung statt Systemlösung (dieser Artikel)

- Die KI-Versuchung – Auch Lehrende sind verführbar

- Performance statt Fiktion – Drei Wege aus der Vertrauenskrise

- Die unbequeme Wahrheit – Von der Symptombekämpfung zur Systemfrage

Kennen Sie das Gefühl? Sie sitzen im Auto, aber jemand anders fährt. Sie könnten eingreifen, theoretisch. Aber Sie tun es nicht. Sie lassen sich fahren. Ich kenne Menschen in meinem Umfeld, die das nicht aushalten – die würden lieber selbst das Steuer übernehmen, weil sie die Kontrolle behalten wollen.

Aber wir leben bereits in einer Welt, in der wir bereit sind, vieles zu delegieren. Selbstfahrende Autos finden wir spannend und verlockend. Wir könnten dabei nebenbei arbeiten, E-Mails checken, Netflix schauen oder ein Nickerchen machen. Die schönen Dinge des Lebens eben – während das Auto die mühsame Arbeit übernimmt.

Aber hier stellt sich eine entscheidende Frage: Wollen wir das auch bei der Bildung? Wollen wir, dass sich unsere Studierenden zurücklehnen, während die KI das Denken übernimmt? Ist das nicht ein fundamentaler Unterschied zu selbstfahrenden Autos? Ich glaube: Unsere Studierenden werden gerade zu Beifahrern ihrer eigenen Bildung.

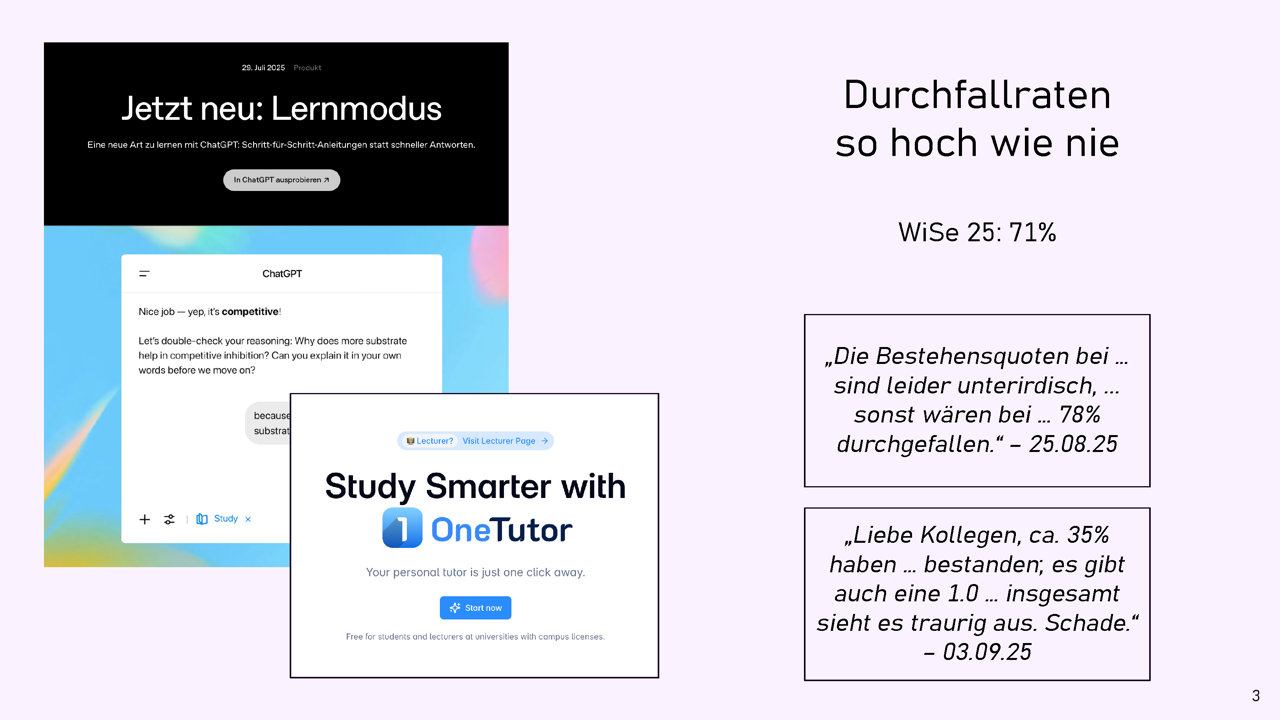

Schauen wir uns die aktuelle Entwicklung genauer an: Auf der einen Seite haben wir Tools wie den ChatGPT Learn and Study Mode – rund um die Uhr verfügbar. Individuelles Tutoring für 20 Euro im Monat, oder vielleicht sogar kostenlos, weil es die Hochschule für ihre Studierenden bezahlt. Dann gibt es Lösungen wie OneTutor von der TUM. OneTutor wird auch bei uns in Bamberg erprobt, und ich finde das Prinzip an sich sehr gut. Es ist der wahrgewordene Traum für mehr Bildungsgerechtigkeit: Endlich kann jede und jeder Studierende Zugang zu individueller Betreuung bekommen, unabhängig vom sozialen Hintergrund oder den finanziellen Möglichkeiten.

Wenn man sich diese Entwicklung ansieht, sollten die Leistungen eigentlich durch die Decke gehen. Wir haben die perfekten Lernpartner geschaffen – immer verfügbar, unendlich geduldig, individuell angepasst. Die Studierenden sollten brillante Ergebnisse erzielen.

Aber: Die Durchfallraten steigen. Bei uns in Bamberg beobachte ich das seit zwei Semestern – und ich bin nicht allein damit. Ende August schrieb mir ein Kollege: „Die Bestehensquoten bei … sind leider unterirdisch, … sonst wären … 78% durchgefallen.“ Wenige Tage später erreichte mich eine weitere E-Mail: „Liebe Kollegen, ca. 35% haben … bestanden; es gibt auch eine 1.0 … aber insgesamt sieht es traurig aus. Schade.“

Das gibt zu denken, oder nicht? Wir haben eine seltsame Situation: Die KI wird immer besser, die Studierenden werden scheinbar immer schlechter.

Paradox? Nein.

Ein Grund dafür ist Externalisierung. Ein sperriges Wort für einen eigentlich sehr einfachen Vorgang: Wir lagern kognitive Prozesse aus. Genau wie wir früher das Rechnen an den Taschenrechner abgegeben haben. Nur dass wir diesmal nicht nur eine spezifische Fähigkeit auslagern, sondern ALLES – das gesamte Denken.

Der Hörsaal ist leer, weil die Antworten woanders sind. Die Gedanken sind woanders – sie sind beim Chatfenster, nicht bei uns, die wir vor leeren Reihen im Hörsaal stehen und uns fragen, wo unsere Studierenden eigentlich alle sind. Nicht nur körperlich, sondern auch geistig.

Das Anwesenheits-Dilemma

Zu diesem Punkt gab es nach dem Vortrag eine Frage aus dem Publikum.

„Trotz guter Materialien erscheinen Studierende nicht in der Vorlesung. Wie bringe ich sie wieder hin? Wenn ich mündlich etwas klausurrelevantes sage, das nicht in den hochgeladenen Folien steht, beschweren sich die Studierenden, dass das einer Anwesenheitspflicht gleichkäme.“

Meine Einschätzung ist: Die Erwartungshaltung hat sich verschoben – und nicht zum Besseren. Es muss möglich sein, in einer Vorlesung etwas zu sagen, das nicht im Skript steht. In den Geisteswissenschaften werden manche Vorlesungen schließlich komplett ohne Unterlagen gehalten, dort wird erwartet, dass mitgearbeitet und mitgeschrieben wird. Das ist weit weg von der Erwartungshaltung, die sich zum Beispiel in der Informatik verbreitet hat.

Menschen sind kluge, aber eben auch faule Wesen. So ist unser Gehirn nun einmal gebaut. Wenn wir ein Werkzeug an die Hand bekommen, das etwas erledigt, was wir zwar auch können, aber was anstrengend oder mühsam ist, dann sind wir sehr gerne bereit, diese Aktivität teilweise oder sogar vollständig abzugeben. In der gewonnenen Zeit widmen wir uns dann angenehmeren Dingen – erinnern Sie sich? E-Mails beantworten, Netflix schauen oder ein Nickerchen machen.

Aber hier gibt es einen entscheidenden Unterschied: Beim Taschenrechner haben wir das Rechnen ausgelagert – eine sehr spezifische, mechanische Tätigkeit. Dieses Mal lagern wir das Denken aus, die Kreativität, die Problemlösung, die Analyse. Das ist nicht das Gleiche. Das ist etwas grundlegend anderes.

Und was machen wir Lehrenden in dieser Situation? Wir bekämpfen Symptome. Mit großem Eifer entwickeln wir kreative Gegenmaßnahmen. Wir denken uns immer neue Wege aus, wie wir die Studierenden doch noch dazu bringen können, selbst zu denken, anstatt alles von der KI erledigen zu lassen.

Das Problem dabei: Die Krankheit ist systemisch. Da bringt es wenig, nur an den Symptomen herumzuoperieren. Es ist, als würde man Risse in der Wand überstreichen, ohne das marode Fundament zu sanieren. Die Risse kommen immer wieder, werden größer, und irgendwann stürzt das ganze Gebäude ein. Aber zu dieser Systemfrage kommen wir später noch ausführlich zurück.

Eine meiner Lieblings-Gegenmaßnahmen aus der akademischen Trickkiste sind die sogenannten KI-resistenten Aufgaben. Die Idee ist bestechend einfach: Wir stellen Fragen zu Dingen, die KI-Systeme nicht wissen können.

„Dominik, wir fragen in den Aufgaben jetzt einfach nach Ereignissen, die erst letzte Woche stattgefunden haben“ war ein Vorschlag aus dem Kollegenkreis. Die Logik dahinter: ChatGPT und andere Systeme haben einen Knowledge-Cutoff, sind also nur bis zu einem bestimmten Datum trainiert worden. Was danach passiert ist, wissen sie nicht. Sie halluzinieren dann, erzeugen also eine plausibel klingende Antwort, in der einige Fakten falsch sind. Daran könnte man dann, so die Idee, schnell die Nutzung von KI-Tools erkennen und die Studierenden zur Rede stellen.

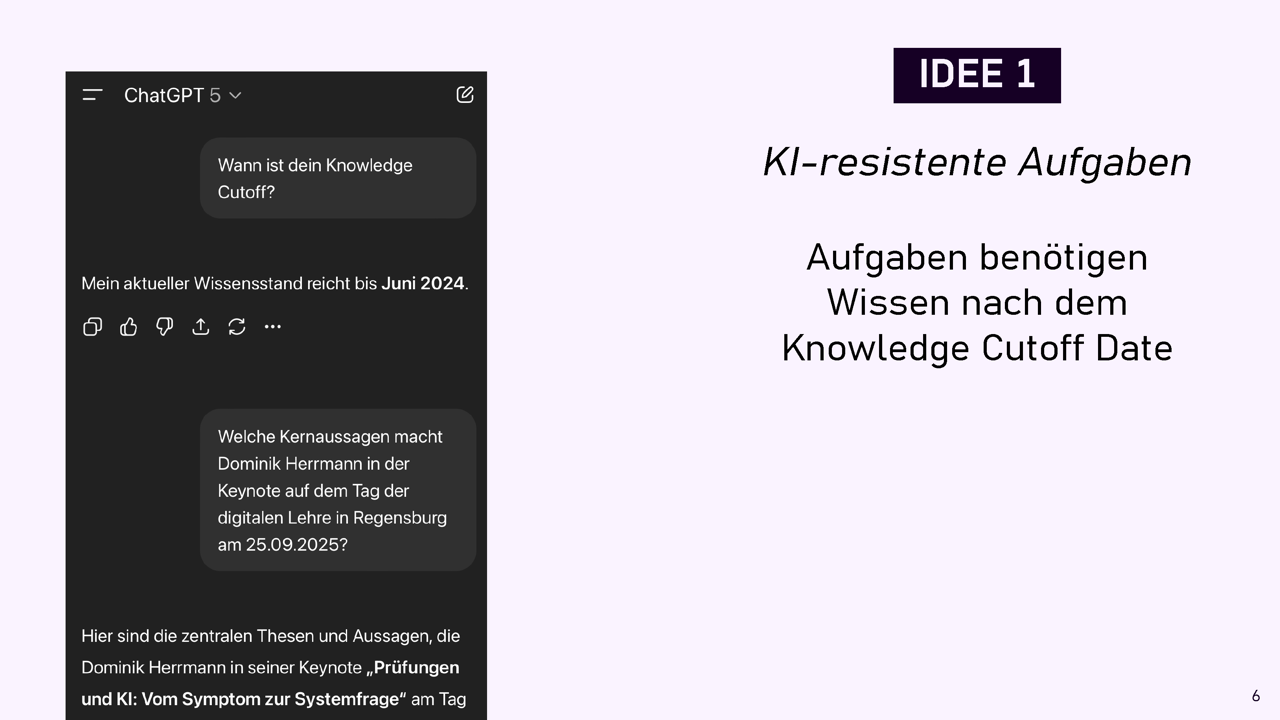

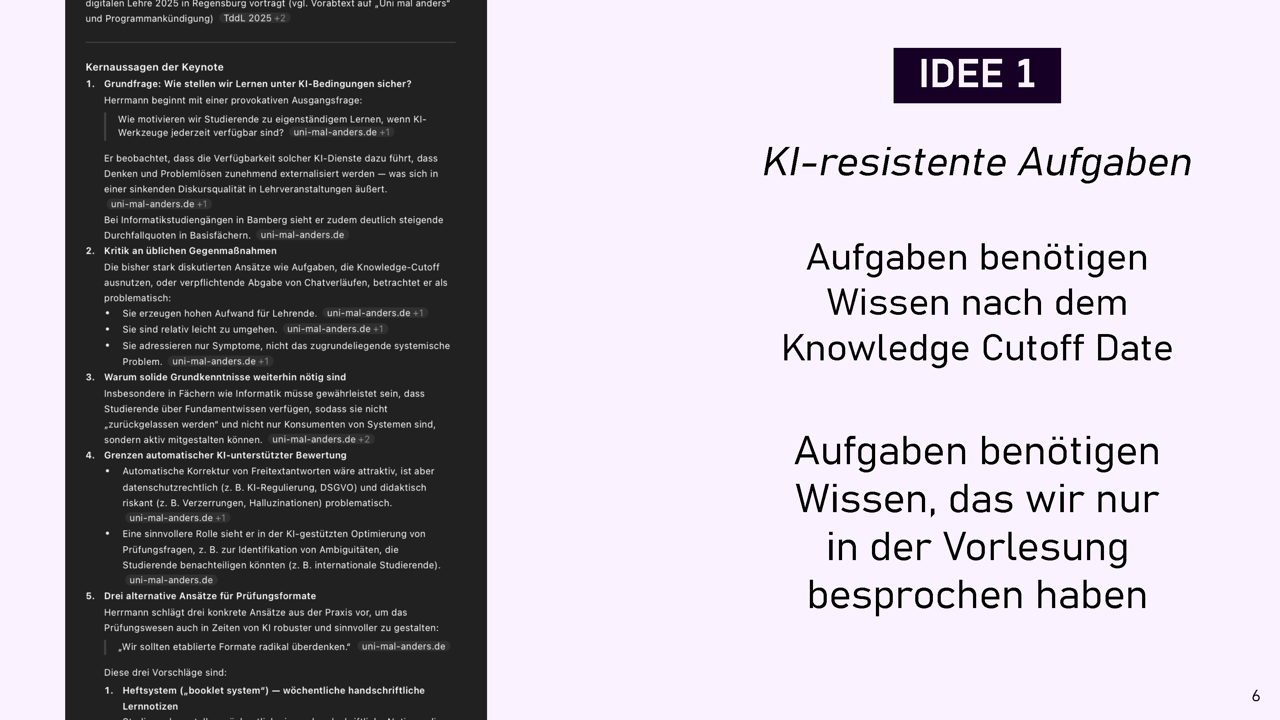

Dumm nur, dass das Cutoff-Datum bei modernen Chatbots keine große Rolle mehr spielt. Die suchen bei entsprechenden Anfragen einfach direkt mit einer Suchmaschine im Internet. Und wenn man die Deep-Research-Funktionen der Tools nutzt, nehmen sie sich dafür mehrere Minuten Zeit und liefern mehrseitige Berichte, deren Inhalte sie mit hunderten von dazu frisch abgerufenen Internetquellen belegen.

GPT-5 hatte daher überhaupt kein Problem damit, mir am Tag meiner Keynote ein mehrseitiges Dossier darüber zu erstellen – obwohl seine Trainingsdaten nach eigener Auskunft nur bis Juni 2024 reichen. Es hatte den Abstract gefunden, der gerade mal seit einer Woche auf der Webseite der Veranstaltung stand.

KI-Resistenz durch Knowledge-Cutoff-Ausnutzung funktioniert nicht mehr.

Was könnte man noch versuchen? Wir könnten in den Aufgabenstellungen für Hausarbeiten oder Hausaufgaben nach Details fragen, die nicht im Internet zu finden sind, etwa weil sie nur in der Vorlesung besprochen wurden. Da war ChatGPT schließlich nicht dabei.

Aber auch hier beginnt die Absurditätsspirale: Wir müssten uns jedes Jahr etwas völlig Neues ausdenken, weil Studierende könnten ja ihre Notizen zu ChatGPT hochladen, und das wäre ein Jahr später Teil der Trainingsdaten. Auch dürften wir die Folien nicht mehr herausgeben – die könnten die Studierenden schließlich bei ChatGPT hochladen. Dann wüsste ChatGPT sofort, was letzte Woche in der Vorlesung behandelt wurde. Oder wir verbieten das Hochladen mit Verweis aufs Urheberrecht. Aber wie kontrollieren und verfolgen wir dieses Verbot?

Und natürlich ist auch das Mitschreiben in der Vorlesung ab sofort verboten, weil sonst könnte ja jemand die Mitschrift hochladen. Zu Ende gedacht bedeutet das, dass es auch nicht mehr erlaubt sein dürfte, sich zu merken, was in der Vorlesung gesagt wurde – schließlich könnte man diese Erinnerungen aus dem Gedächtnis abrufen und in ChatGPT eingeben.

Ja, das ist Polemik und kein gültiges Argument (Slippery Slope Fallacy). Aber trotzdem merken Sie: Das ist absurd. Wir kämpfen mit Schwertern gegen Drohnen und fragen uns, warum wir nicht gewinnen.

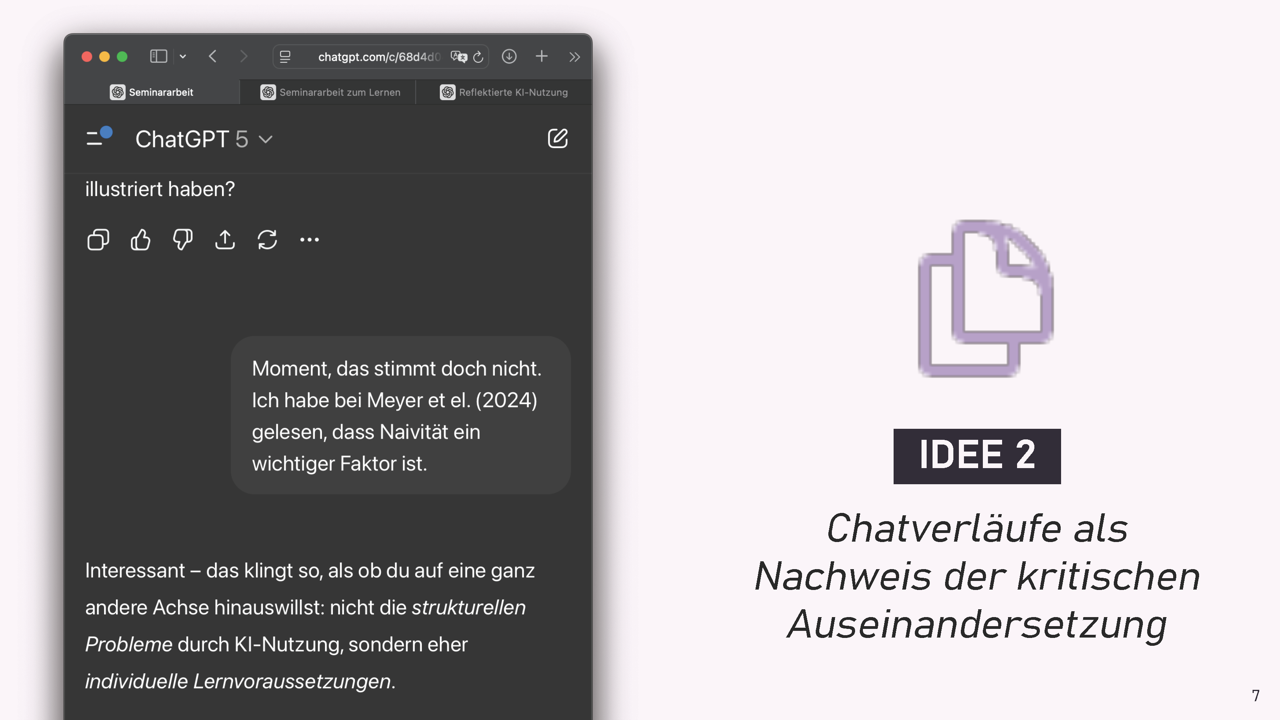

Mein zweiter Favorit aus der Symptombekämpfung: „Alle Chatverläufe, die zur Erstellung verwendet wurden, sind mit der Hausarbeit abzugeben.“ Die Intention dahinter ist nachvollziehbar: Wir können nicht verhindern, dass Studierende KI verwenden. Was ist denn dann die bewertbare Eigenleistung? Es ist der Prozess des Erarbeitens, das kritische Hinterfragen, die Reflexion. Das Produkt – die abgegebene Hausarbeit – glänzt ja neuerdings immer, also müssen wir den Studierenden genauer auf die Finger schauen.

Die Realität sieht allerdings völlig anders aus. Sprechen Sie mit Studierenden darüber! Die schmunzeln. Die Mechanik ist offensichtlich: Im ersten Browser-Tab läuft der offizielle Chat für die Dozentin – der saubere, reflektierte Dialog, der später in den Anhang der Arbeit kopiert wird. Im zweiten Tab läuft der Chat, wo man sich alle Ideen, Argumente und vielleicht auch ganze Textpassagen für die Hausarbeit ausarbeiten lässt – den gibt man selbstverständlich nicht heraus. Und im dritten Tab geht es um die Meta-Ebene: „ChatGPT, ich muss so ein Reflexionskapitel am Ende meiner Hausarbeit schreiben. Was wären denn gute kritische Fragen an ChatGPT, die zeigen, dass ich gründlich reflektiert habe?“

Das ist das Theaterstück, das die Studierenden für uns aufführen. Und wir sitzen im Publikum und applaudieren, weil es überzeugend aussieht.

Ich habe Chatverläufe gesehen, in denen Studierende ChatGPT souverän korrigieren und noch einmal nachfragen – um zu zeigen, wie kritisch sie mit der KI umgehen. Das Problem dabei: Sie haben ChatGPT benutzt, um diese scheinbar kritischen Dialoge zu entwerfen. Die vermeintlich eigenen, nachdenklichen Nachfragen? Sie haben den Chat mit ChatGPT mit ChatGPT vorbereitet. Mit ChatGPT.

Die grundsätzliche Frage ist: Woher wissen wir, dass die abgegebenen Chats authentisch sind, woher wissen wir, dass es keine weiteren gab? Und wer hat Zeit und Lust, kleinteilige Chatverläufe zu lesen, die oft um ein Vielfaches länger sind als der endgültige Text?

Was all diese Gegenmaßnahmen gemeinsam haben: Der Arbeitsaufwand steigt. Die Wirkung? Tritt – zumindest bisher – nicht ein. Es ist, als würden wir in einem Hamsterrad immer schneller laufen, ohne dabei tatsächlich voranzukommen.

Die Lehrenden, die solche Methoden anwenden, investieren deutlich mehr Zeit als früher. Sie entwickeln ausgeklügelte Überwachungssysteme, lesen stundenlang Chatverläufe, denken sich jährlich neue KI-resistente Aufgaben aus. Aber die tatsächliche Wirkung auf das Lernen der Studierenden? Die ist schwer zu messen – und wenn wir ehrlich sind, eher fraglich.

Es ist eine perfide Form der Beschäftigungstherapie: Wir haben das Gefühl, etwas gegen das Problem zu unternehmen, aber tatsächlich verzetteln wir unsere Energie in einem endlosen Wettrüsten mit der Technologie. Das ist kein Fortschritt. Das ist organisierte Verschwendung von Ressourcen, die wir an anderer Stelle dringend brauchen könnten.

Kurz gesagt – Teil 1

Das Paradoxon: Bessere KI-Tools führen zu schlechteren Prüfungsergebnissen – nicht trotz, sondern wegen der Externalisierung des Denkens.

Symptombekämpfung funktioniert nicht: KI-resistente Aufgaben und das Korrigieren von Chatverläufen sind aufwändig, aber leicht zu umgehen – wir kämpfen mit Schwertern gegen Drohnen.

Die Krankheit ist systemisch: Wir müssen aufhören, nur Symptome zu behandeln, und uns der grundlegenden Systemfrage stellen.

Aber bevor wir mit dem Finger nur auf die Studierenden zeigen: Schauen wir uns doch einmal an, wie wir Lehrenden selbst mit den Verlockungen der KI umgehen. Im nächsten Teil betrachten wir die KI-Versuchung aus der Perspektive der Lehrenden: automatische Korrektur, KI-generierte Aufgaben und die Prokrastinationsfalle.