KI im Praxiseinsatz: Chancen und Grenzen bei E-Prüfungen (Teil 2/4)

Artikelserie: KI und Datenschutz bei E-Prüfungen

In diesem 2. Teil untersuchen wir den praktischen KI-Einsatz bei E-Prüfungen: Was funktioniert, was nicht, und warum die automatische Bewertung noch Zukunftsmusik ist.

Bisher erschienen:

Weitere Teile:

Im ersten Teil haben wir die Grundlagen von psi-exam und die fundamentalen Zielkonflikte bei E-Prüfungen kennengelernt. Nun wenden wir uns der Frage zu, wie KI-Werkzeuge konkret eingesetzt werden können – und wo die Grenzen liegen.

KI im Prüfungseinsatz: Pragmatische Praxis

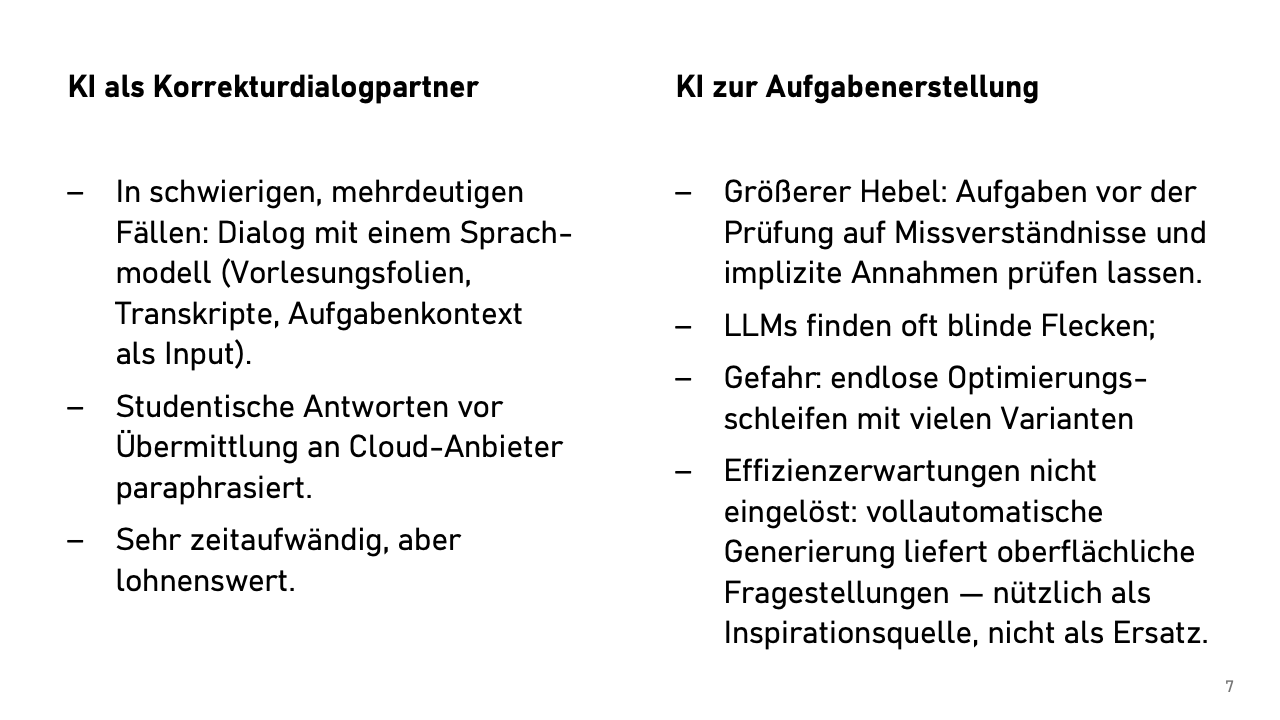

Die erste KI-Anwendung entstand aus der Praxis heraus. Bei der Korrektur stößt man immer wieder auf Antworten, die einen ins Grübeln bringen: Nicht falsch, nicht richtig, sondern … anders. Früher hätte man vielleicht eine Kollegin oder einen Kollegen gefragt – falls sich jemand findet, der Zeit und Lust hat, sich in das Problem hineinzudenken. Heute können wir das einfach mit einem Sprachmodell erledigen. KI wird zum Korrekturdialogpartner.

Tatsächlich ist der Anreiz für Prüfende, sich Grenzfälle genauer anzuschauen, bei unserem System größer als sonst. Schließlich droht durch die niedrigschwellige Online-Einsicht andernfalls eine reale Gefahr, dass sich Prüflinge bei einer grenzwertigen Korrektur melden –und darauf zu reagieren kostet dann definitiv mehr Arbeit. Also haben Prüfende einen Anreiz, schon bei der Korrektur gründlich zu sein.

Der Prozess sieht so aus: Wir paraphrasieren die Antworten der Prüflinge (Urheberrecht, Datenschutz!), geben dem Sprachmodell Vorlesungsfolien, eventuell auch die Vorlesungstranskripte, die konkrete Aufgabenstellung und benachbarte Aufgaben und fragen dann sinngemäß: „Könnte die Interpretation dieser Person ebenfalls eine gültige Antwort auf die Frage sein, wenn wir eigentlich die folgende Antwort erwartet hatten oder ist die Antwort fachlich falsch oder zu uneindeutig?“

Das Ergebnis: Extrem fundierte, halbseitige Begründungen, warum eine Antwort richtig oder falsch ist, oder warum sie zwar an sich falsch ist, aber „angesichts der mehrdeutigen Formulierung auf Vorlesungsfolie 47 unten links“ durchaus auch als korrekt angesehen werden könnte.

Zeitaufwändig? Absolut. Das macht man pro Klausur nur bei ein paar Antworten. Aber diese Fälle decken oft Mehrdeutigkeiten oder Fehler in Vorlesungsmaterialien auf, die uns vorher nicht bewusst waren.

Der größere Hebel beim KI-Einsatz durch Prüfende liegt aber in der Prüfungserstellung. Wir entwickeln für fast jede Prüfung neue Aufgaben, weil wir den Studierenden aus Transparenzgründen sämtliche Altklausuren mit Musterlösungen zur Verfügung stellen. An neue Aufgaben stellen wir hohe Anforderungen: fair, präzise und unmissverständlich müssen sie sein.

Hier glänzen aktuelle KI-Werkzeuge. Wir fragen: „Ist diese Formulierung auch für unsere Studierenden aus Asien verständlich? Können wir davon ausgehen, dass sie die in der Aufgabe verwendeten Begriffe (‚Bergstation' und ‚Almhütte') verstehen?“ Was für uns normal ist, kann für Menschen aus anderen Kulturkreisen höchst verwirrend sein. Die Modelle finden regelmäßig blinde Flecken, geben eine Einschätzung zu Fairness und Schwierigkeitsgrad.

Die Schattenseite: Man kann sich in endlosen Optimierungsschleifen verlieren. Nach drei Stunden hat man 37 Varianten einer Aufgabe, keine eindeutig besser. Sicher keine Zeitersparnis, aber vielleicht bessere Prüfungsfragen. Wer zur Prokrastination neigt, sollte sich vielleicht einen Timer stellen.

Natürlich haben wir auch versucht, komplette Prüfungen generieren zu lassen. „Erstelle fünf Aufgaben zu jedem Themenbereich aus der Vorlesung (basierend auf dem hochgeladenen Material).“ Das Ergebnis? Multiple-Choice und Definitionsabfragen. Fachlich korrekt, didaktisch belanglos – für uns wenig nützlich.

Trotzdem sind KI-Werkzeuge bei der Aufgabenerstellung eine große Hilfe, sei es mit neuen Beispielszenarien, cleveren Variationen von Standardaufgaben oder alternativen Formulierungen. Also: Zur Inspiration gut, als Ersatz für menschliche Aufgabenerstellung noch nicht.

KI zur automatischen Bewertung

Die Verlockung ist groß: Alle Antworten hochladen, Notenliste zurückbekommen. Die Realität ist ernüchternd.

Mit Cloud-Modellen (GPT-4, Claude) funktioniert die Bewertung erstaunlich gut –aber datenschutzrechtlich ist es ein Alptraum. EU AI Act, DSGVO, Hochrisikobereich nach KI-Verordnung, die Weitergabe von Prüfungsdaten an US-Anbieter … selbst mit einer Vereinbarung zur Auftragsdatenverarbeitung bewegen wir uns dann auf dünnem Eis.

Was ist mit lokalen Modellen? Zumindest das Datenschutzproblem ließe sich damit etwas einfacher lösen. Die Qualität? Aktuelle 7-Milliarden-Parameter-Modelle sind für die Korrektur unserer Programmier- und Freitextaufgaben unbrauchbar, sie machen dabei viel zu viele (subtile) Fehler. Bei den großen Modellen mit 70 Milliarden Parametern sieht es schon besser aus, aber immer noch unbefriedigend.

Das eigentliche Problem ist aber ein anderes, es ist psychologischer Natur: Die Bewertungsvorschläge der KI klingen ja immer plausibel. Nach 20 Würdigungen wird man vielleicht nachlässig und schaut nicht mehr so genau hin; wird schon passen! Die „Letztkontrolle“ durch die Prüfenden ist anstrengende Arbeit! Man muss die Antwort lesen, dann die KI-Würdigung und dann noch schauen ob sie zusammenpassen. Automatisierte Bewertung macht mehr Aufwand, als wenn man sich selbst eine Meinung bildet. Ich sehe darin bisher keinen Gewinn, sondern nur mehr Arbeit und vor allem unnötige Angriffsfläche.

Ich habe auf anderen Prüfungssymposien mit Leuten geredet, die euphorischer sind. Ich weiß noch nicht genau, was wir tun müssen, damit die nicht falsch abbiegen.

Learning Analytics – machen wir noch nicht. Theoretisch könnten wir auch Daten aus dem Lernmanagementsystem mit Prüfungsergebnissen verknüpfen: „Achtung! Studierende mit ähnlichem Lernverhalten wie Sie hatten 30 Punkte weniger in der Klausur.“ Ein Kollege forscht dazu mit beeindruckenden Ergebnissen: Solche Feedback-Interventionen führen zu höheren Teilnahmeraten an Prüfungen und auch zu besseren Prüfungsleistungen.

Ethisch problematisch? Datenschutztechnisch ein Mammutprojekt? Wahrscheinlich, ja! Bei uns daher aktuell nicht umgesetzt, aber ein gutes Thema für die Diskussion.

KI-Werkzeuge sind für Prüfende keine Wunderwaffe, sondern Werkzeuge: Gut zur Qualitätssicherung und Reflexion; Automatisierung ist aber problematisch. Der Arbeitsaufwand sinkt nicht, er verschiebt sich. Statt schneller zu korrigieren, korrigieren wir gründlicher. Das ist aber kein Bug, sondern ein Feature.

Aber Moment –haben wir nicht etwas vergessen? Was ist mit dem zweiten Teil unseres zweiten Zielkonflikts: Wie verhindern wir Täuschungsversuche oder decken diese auf? Könnte man da nicht mit einer KI … nein, auf gar keinen Fall!

Kurz gesagt – Teil 2

KI als Werkzeug, nicht als Ersatz: Stärken bei Qualitätssicherung und Aufgabenprüfung, Schwächen bei automatischer Bewertung.

Der Aufwand verschiebt sich: Wir korrigieren nicht schneller, sondern gründlicher – ein Feature, kein Bug.

Datenschutz bleibt kritisch: Cloud-Modelle funktionieren gut, sind aber rechtlich problematisch. Lokale Modelle sind noch nicht ausgereift.

Im nächsten Teil widmen wir uns der heiklen Balance zwischen Datenschutz und Kontrolle: Wie verhindern wir Täuschungsversuche, ohne die Privatsphäre zu verletzen?

Bonus: Aus der Diskussion

KI als Erstkorrektor?

Frage: Könnte man die erste Korrektur komplett von KI machen lassen und nur die Zweitprüfenden schauen drüber?

Antwort: Technisch machbar, aber wohl rechtlich und psychologisch problematisch. Bei jetziger Technologie müssten die Zweitprüfenden faktisch alles noch einmal vollständig korrigieren - das ist für sie mehr Arbeit, nicht weniger. Die psychologische Falle: KI-Bewertungen klingen immer plausibel, die Versuchung sie ungeprüft zu übernehmen ist real.

Andere technische Lösungen

Input aus dem Publikum:

- Case Train (Uni Würzburg): individuelle Zeitverlängerung möglich, Analyse von Tippverhalten zur Täuschungserkennung (Copy-Paste-Verhalten)

- Proctorio und andere US-Anbieter: Drittlandstransfer-Probleme, Grundrechtseingriffe bei Nutzung privater Geräte